Vilka aspekter saknas ur användarperspektiv för att immersiv teknik ska få oss att byta ut våra telefoner mot glasögon och headsets? Hur vi interagerar med det digitala är en nyckelfaktor! Om utvecklingen har gått från tangentbord och mus… till touchskärmar… vad är det som kommer göra vårt användande av VR/AR till den mest naturliga interaktionen med teknik hittills? Häng med när vi utforskar användarvänlig teknik på den yttersta spetsen, i vår djupdykning i interaktionsverktyg och gränssnitt för virtual och augmented reality!

Innehåll

Bakgrund: Handkontroller och andra inputs för VR/AR

VR och AR är en teknik som kopplar ihop människan med maskinen/det digitala på ett mer direkt sätt än något annat. Visst går det att definiera VR som de klumpiga headsets som vi använder idag… men tittar man på vart utvecklingen barkar så handlar VR/AR egentligen om “ett biotekniskt input/output-system”. Det säger dig säkert ingenting, så låt mig utveckla!

Vi tar synen som exempel – vårt främsta sinne och det enklaste att exemplifiera med: VR-glasögon har kameror (bildsensorer) som tar input från hur vi rör oss i vår omgivning (på samma sätt som våra ögon skulle göra annars) – vilket omvandlas till en output i form av positionsspårning som ger oss en känsla av kroppslig närvaro och rörelsefrihet i en syntetisk 3D-värld.

På samma sätt strävar VR/AR efter att ta ALL input från våra sinnen och motoriska handlingar och mata det tillbaka till oss i form av upplevelser och aktiviteter – eller digitala drömvärldar och superkrafter. (Man kan se filmen Matrix som ett klockrent exempel på ”mer eller mindre tekniskt perfekt VR”.)

Händerna är våra huvudsakliga output-mekanismer för att påverka världen omkring oss. Vi är vana vid att använda tangentbord, touchskärmar, möss eller spelkontroller av olika slag för att interagera med det digitala.

I VR har vi fått avancerade rörelsekontroller som fungerar både som 3D-möss/“händer” och dessutom har ordentliga uppsättningar med knappar och spakar. VR-utvecklingen drivs som bekant just nu mest av spel, vilket dessa kontroller passar ypperligt till.

På Oculus Connect 6 hörde vi dock två utannonseringar från Mark Zuckerberg själv som sade mycket om riktningen framåt för Oculus/Facebook. Dels fick vi bekräftat att de faktiskt jobbar på AR-glasögon (som om vi inte visste det redan…) och dels så släpptes nyheten om den kommande mjukvaruuppdateringen till Oculus Quest som kommer ge oss handspårning genom kamerorna fram på headsetet!

När de demonstrerade och pratade om de nya handinteraktionerna i VR så låg fokuset på företagsanvändning. (Och målet med AR-glasögon kommer såklart vara att ersätta våra mobiltelefoner som den device vi använder till ALLT, hela dagarna.)

Utvecklingen kan på sikt gå mot att hardcore-gaming blir en liten nisch av VR (och AR), och att handkontroller typ Touch bara används i den nischen. I alla andra fall så kommer man klara sig utan separata kontrollprylar.

Men hur då? I resten av denna artikel bryter vi ner problemet och tittar på hur befintlig teknik kan lösa det – och ge oss oanade nivåer av kontroll i vår framtida digitala vardag.

Begränsning med handkontroller

En anledning att vilja röra sig bort från handkontroller är som sagt att de är inriktade på spel, inte kommunikation / social interaktion eller produktivitet. Våra händer är det mest uttrycksfulla verktyget vi har, och vi vill frigöra hela den uttrycksskalan.

Handkontroller för spel är dessutom i vägen i vardagen. De är inte direkt något vi bär på oss utanför vår dedikerade speltid. Idag plockar vi upp våra telefoner ur fickan hundratals gånger om dagen utan att tänka på det (eller knappar på/talar med vår smartklocka). Gränssnittet för AR-glasögon för daglig användning måste ha ännu mindre friktion än det beteende vi redan är vana vid. Att plocka upp spelkontroller ur en väska? Inte särskilt friktionsfritt.

Varför har vi inget bättre än spelkontroller för VR/AR-input?

Hur kommer det sig då att vi inte har sett några bra alternativ till VR-handkontroller för input i VR/AR? Det saknas inte duktiga och dedikerade ingenjörer och designers som försöker ge oss den optimala lösningen, men här är några problem de brottas med:

- “Bara en pekare?” Till Gear VR och Google Daydream fick vi en enkel kontrol med ett par knappar på, som kände av hur vi lutade/roterade kontrollen. Till biffiga AR-headsetet Magic Leap har vi en liknande “pekare” men som också spårar kontrollens position i rummet. Gemensamt för de båda är att de förvisso är enkla och intuitiva, men de ger oss ännu mindre uttrycksmöjlighet än handkontrollerna.

- Handskar då? Det är ett lovande spår, och kanske kommer vi landa i en version av dem åtminstone för VR – precis som i Ready Player One. Idag begränsas det av klumpig teknik för att få till både spårning och motstånd, utmaningen att passa för alla händer, och att materialet måste vara hygieniskt.

- När det gäller den “smidigare” lösningen med optisk handspårning så finns, förutom den tekniska utmaningen med precision, den stora begränsande faktorn att man saknar taktil feedback. När vi omges av digitala objekt och miljöer som ger oss en visuell illusion så bryts den illusionen lätt om vi inte kan ta på den digitala världen.

Så, hur jobbar man sig då runt svårigheterna med funktion vs expression, otymplig design och önskan att “känna” på den digitala världen? Nedan går vi igenom de olika spår eller kategorier av VR/AR-interaktion som är under utveckling:

Översikt: Nya sorters gränssnitt för VR/AR

Låt oss nu ta en titt på vilka andra sorters input som finns i utveckling. Notera att detta inte är en lista på produkter som finns att köpa – de är alla i tidig fas och är antingen bara experiment/prototyper eller endast tillgängliga för företag med ordentlig budget.

Ögonstyrning

Svenska Tobii är en av ledarna på detta område, och står för ögonspårningstekniken i HTC’s Vive Pro Eye. Både Apple, Microsoft och Facebook har gjort strategiska uppköp av andra ögonspårningsaktörer. För både VR och AR kommer ögonstyrning utan tvekan vara en del i framtida produkter.

Läs mer: Foveated rendering och andra anledningar att ögonspårning är en nyckelteknik för VR/AR

Röst

Alla VR-headset och de flesta AR-glasögon har mikrofoner, och den AI som driver taligenkänning utvecklas framåt i en rasande fart. Samtidigt drivs också paradigmet med “conversational UI” / dialogbaserade gränssnitt av den växande användningen av chatbottar i kundservice, smarta högtalare för hemmet och andra tillämpningar. Visst önskar vi oss alla en effektiv AI för att styra tekniken omkring oss, typ som Tony Starks Friday och Jarvis, eller som Samantha i Her?

(Ett spännande, relaterat spår är “silent text to speech”, och ett annat är forskningen om röststyrning med viskningar)

(Optisk) kroppsspårning

I VR vill man gärna ha hela sin kropp representerad med alla dess rörelser och uttryck, snarare än bara huvudet och händerna. Då skulle vi kunna dansa, spexa eller utöva idrott på ett sätt som inte går idag.

Å ena sidan går detta att få till genom att sätta sensorer på kroppen, som spåras utifrån – precis samma princip som motion capture-dräkter för filmspecialeffekter. Detta används faktiskt idag av hardcore-VR-entusiaster – men det är alldeles för meckigt och ingen väg framåt för framtidens “vARdag”.

Microsoft har länge utvecklat och använt Kinect, en typ av 3D-kamera, för effektiv kroppsspårning som bl a har använts i Xbox-spel, och snart kommer den nya ännu mer kapabla Kinect Azure ut på marknaden. Facebook har också avslöjat delar av deras hemliga forskning på kroppsspårning som ska gå att göra med vanliga smartphonekameror.

Fast hur ska det gå till i vårt vardagliga liv? Ska vi vara ok med att alltid bli filmade/scannade av övervakningskameror vart vi än går? Ha privata kameradrönare med oss för att kunna överföra vårt hologram till andra platser i realtid?

Nej, det troliga scenariot är att vi kommer ha en form av stationär kamera i hemmet (kanske den som redan sitter i vårt videosamtalssystem typ Portal). Den kameran kan vi använda när vi behöver spara en avatar-scan eller när vi vill gå in i VR med en extra nivå av fysisk närvaro.

(Ett sidospår som har koppling till detta är aspekten av haptisk feedback över hela kroppen, där det finns dräkter typ Teslasuit tillgängliga för företag redan idag. Återigen associationer till Ready Player One… Och kanske leder också detta forskningsprojekt för syntetiskt skinn till en liknande produkt i framtiden.)

Handskar

Vi har redan berört problemen med handskar för VR i sektionen ovan. Även om de kan ge oss mer kraftfull inlevelse och den fysiska känslan av att interagera med saker så är formfaktorn tyvärr inte riktigt “framme” med dagens teknik.

Haptix t ex har utvecklat denna tunga handske:

… Och här är Dexmo från Kina. (Kolla in denna djupa genomgång av Dexmo från Tony på bloggen Skarredghost!) Båda dessa är inriktade på företagsbruk och kan ge ökad inlevelse och förbättrad effekt när man tränar olika arbetsmoment i VR.

Facebook/Oculus forskar på en lättare variant av handskar. Kanske blir detta en ny standard för VR.

Handgester / optiskt

När det gäller låg tröskel för interaktion i VR och AR så är optisk handspårning ett lovande spår. Leap Motion har länge gått att använda tillsammans med VR, och i deras AR-koncept North Star så visas prototyper av gränssnitt som ser ut att kunna bli en vinnare.

Även Microsoft satsar stort på handspårning med Hololens 2.

Oculus Quest får som sagt också en variant av detta som släpps nästa år.

Enligt tidiga tester så är precisionen i deras lösning inte riktigt i samma nivå som Leap Motion, men man kan räkna med att de lägger massor av ansträngningar på att göra det bättre. För enkla spel och företagsbruk med användare som inte är vana datorspelare betyder handspårning en massiv sänkning av friktion.

Relaterat: Svenska Capwings har en innovation på gång i form av ett slags Leap Motion-liknande pryl som man sätter fast på handryggen och som kan spåra fingrarnas rörelser.

Muskulärt / Spatialt (Myo)

Omkring 2014, just när wearable tech seglade ner från megahypen så släppte Thalmic Labs ett slags armband – Myo – som kunde känna av musklers rörelser och tolka gester till input till dator. Företaget bytte nyligen namn till North och skiftade fokus till smarta glasögon, och släppte 2018 den snygga AR-produkten Focals. Den ursprungliga tekniken bakom Myo sålde de till ett annat bolag…

Neurala gränssnitt / BCI (Brain Computer Interface)

Att styra datorn med hjärnan, eller att omvänt få sinnesinputs direkt till hjärnan, är den ultimata VR-drömmen som blev populärkultur med Matrix (eller i animekretsar: Sword Art Online och massor av andra serier och filmer). Elon Musk har med sitt företag Neuralink visat en vision av en “människo-integrerad AI” genom ett implantat bakom örat som ska kunna fånga och sända signaler från/till hjärnan.

Det är lätt att tänka sig att en sån device skulle kunna ge den ultimata “telekinetiska” kontrollen i VR eller AR (och ja, på sikt till och med göra fysiska headsets/glasögon onödiga då de digitala världarna kan skickas direkt till hjärnans syncenter. Men det är ett annat ämne!). Det stora frågetecknet kring teknik som Neuralink är – hur många kommer vara villiga att utsätta sig för hjärnkirurgi för att bli “augmenterade människor”?

Det är där CTRL Labs kommer in i bilden. Med deras prototyp “CTRL Kit” säger de sig ha åstadkommit förmågan att tolka “motor intent” / eller avsikter från hjärnan genom att kunna läsa av nervsignaler på detaljnivå ner till enskilda neuroner. Och CTRL Kit är inget du behöver operera in i hjärnan – det är “bara” ett armband med inåtriktade sensorer.

Minns ni Myo som vi nämnde ovan? Deras muskelavläsningsteknik köptes upp av CTRL Labs tidigare i år, och förstärkte den teknik som CTRL redan forskade på. Genom att läsa enskilda nervsignaler i musklerna så behöver användaren inte ens röra armen eller fingrarna för att få önskad rörelse i VR/AR.

Det betyder att man kan dra till sig eller skjuta ifrån sig objekt – som “force push” i Star Wars – eller skriva text genom att knappra på bordet eller i luften på ett tangentbord som inte finns… eller till och med mata in text genom att tänka. De har även demonstrerat hur du med armbandet kan styra en virtuell hand med SEX fingrar – eller varför inte en sexbent spindelrobot…

CTRL Labs köptes upp av Facebook/Oculus i somras, för en obekräftad prislapp på runt en miljard dollar. Facebook har tidigare beskrivit hur de ser på möjligheterna med (icke-invasiva, till skillnad från Neuralink) neurala gränssnitt, vilket går helt i linje med vad CTRL Labs möjliggör – titta bara på denna visionära presentation från F8 2017:

Ett fängslande citat från Regina Duncan ovan är “semantisk förståelse betyder att du en dag kan få förmågan att dela dina tankar oberoende av språk… för ord är bara komprimerade tankar.”

Framtiden för neurala gränssnitt är hisnande, och den är intimt sammanknuten med framtiden för VR/AR.

Alternativ för känselinput / fysiskt motstånd

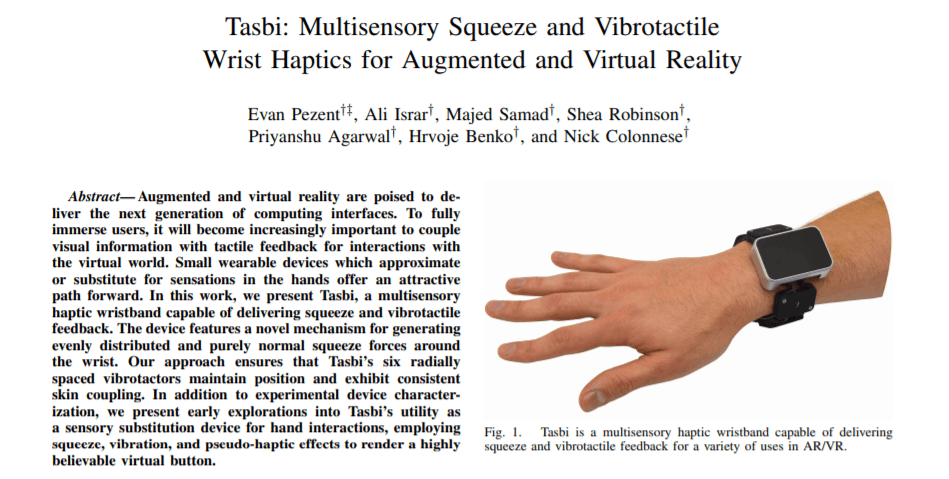

Om vi nu får dessa magiska armband, saknar vi då inte fortfarande den där biten med haptisk feedback? Det visar sig att Facebook jobbar på den biten med. Projektet Tasbi som visades upp i år är också det ett armband, men med motorer som kan vibrera eller utöva tryck på din underarms muskler för att simulera känselstimuli ända ut i fingrarna. Vi kan alltså hålla i och känna digitala objekt, ta på ytor, trycka på knappar, etc…

Får vi den haptiska effekten i samma armband som “CTRL Kit” så har vi därmed båda aspekterna som vi vill åt, och det i en produkt som, med rätt formfaktor, åtminstone jag kan tänka mig att ha på mig och använda dagligen. Det är dock tydligt att det inte kommer bli en skarp konsumentprodukt på några år – gissningsvis om 3-5 år.

(Ett sidospår till detta är Ultrahaptics som har utvecklat en sorts ultraljud-platta som kan stråla ut ohörbart men “kännbart” ljud på kort avstånd. Vi pratar ofta om kopplingen mellan VR/AR och internet of things, och den här tekniken innebär att de elektroniska prylar och objekt vi kommer ha omkring oss också kan interageras med utan att vi fysiskt behöver ta på dem. Ultrahaptics och Magic Leap gick förresten ihop i samma bolag detta år, och heter nu UltraLeap.)

Värt att nämna är slutligen “Project Soli” från Google, som visades som koncept redan 2014 och kom i skarpt släpp i år med deras nyaste telefon Pixel 4. “Motion Sense” som funktionen nu heter, är baserad på radar, och låter oss styra telefonen (och snart fler devices?) med små gester eller vinkningar.

Superhjälte i AR, ”Gud” i VR

Vad är då slutmålet med detta? Vad betyder det att uppnå “perfekt” interaktion i VR eller AR? Ja, det handlar ju om att vi ska kunna leva i helt magiska digitala världar där vi använder vår vilja för att styra det digitala som vi vill. I AR kommer vi kunna kommunicera med datorer och andra människor på oändligt smidigare sätt – när våra AR-glasögon låter oss se genom väggar för att precis allt redan finns inscannat och representerat i ett världstäckande AR cloud kommer vi ha superkrafter i vår vardag. Och i VR kommer vi kunna forma, böja och omskapa världar som vi önskar.

Och ja, på vägen fram tills dess kommer vi kunna göra alla digitala göromål vi ägnar oss åt idag… bara mycket, mycket bättre.

Vad tror du om framtiden för interaktion i VR och AR? Vilka innovationer kommer behövas för att du ska kunna tänka dig att byta bort din smartphone och dator mot framtidens immersiva teknik?